原帖由 "squall1" 发表:

楼主,我又仔细看了一下你的文章,我觉得内核还是用自己编译的好,对于以后troubleshooting比较容易一些。

原帖由 "squall1" 发表:

这里我还是要说一下,咱们用LVS/NAT方式就可以了,您公司的服务器不会超过20台吧?如果有百十多台,我估计您也不会选择LVS。呵呵。

原帖由 "ohor" 发表:

DR方式用非redhat也可以,甚至非linux也可以,已经试过。。

原帖由 "ohor" 发表:

DR方式用非redhat也可以,甚至非linux也可以,已经试过。。

原帖由 hss202 于 2006-2-2 22:30 发表

在VM下,如何设置串口,按楼主说的

一端用 cat </dev/ttys0

另一端用 echo hello > /dev/ttys0

在cat < /dev/ttys0端里没有任何内容输出.请问要怎样测试,如如何确认已连通

原帖由 FunBSD 于 2005-5-19 17:49 发表

http://www.ultramonkey.org/downl ... .2.EL.um.1.i686.rpm

原帖由 wdongtao 于 2006-2-22 10:52 发表

我的as3的内核是2.4.21-15的,而ultramonkey没有针对15的文件,我下载这个安装重启后发现top只能看到一个cpu,而cat /proc/cpuinfo也是一个cpu,各位知道怎么解决吗?

原帖由 lhm2626 于 2006-2-23 14:03 发表

所有Real Server提供共享存储空间和一致的数据内容,能提供些么?

原帖由 squall1 于 2005-5-29 06:49 发表

你可以贴一下相关配置吗?如果我客户端是windows或其他OS,用DR模式。thanks.

原帖由 dgvri 于 2006-10-17 11:03 发表

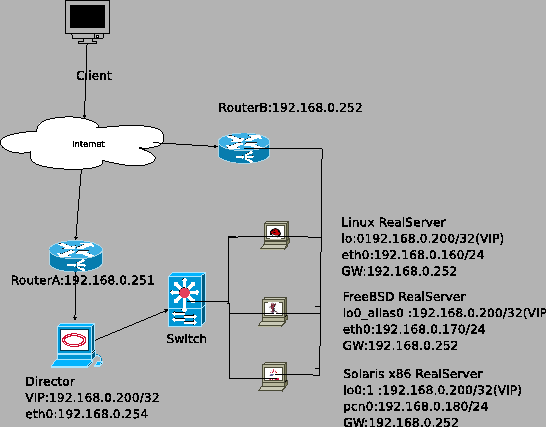

从楼主的图中可以看出,来自user的请求,经load balancer转发到real server上面,而real server返回的数据也经过LOAD BALANCER返回给访问的用户,是这样吧。

可我在本站看的《LVS在Fedora Core5上的配置指南(以L ...

| 欢迎光临 Chinaunix (http://bbs.chinaunix.net/) | Powered by Discuz! X3.2 |